在AWS EC2 Ubuntu上部署OpenClaw (原Clawdbot/Moltbot) 并对接飞书机器人

在AWS EC2 Ubuntu上部署OpenClaw AI助手,通过Bedrock调用Claude模型,配置飞书机器人实现长连接对接,打造成本优化的24小时在线飞书助手。

一、背景

Openclaw是最近火起来的个人助手agent,经历了改名风波抛弃了Clawdbot/Moltbot的名字,正式定名Openclaw。最近网上有许多在Mac上部署Openclaw的文章,AWS官方公众号也发表了在海外AWS云上Mac Mini中部署Openclaw的方法。考虑到成本节约(钱包),这里不使用Mac Mini,本文介绍如何在AWS EC2 Linux上部署一个Openclaw,并通过飞书机器人实现与飞书对接,实现一个always在线的飞书助手。

关于Openclaw的技术本身,在2026年2月这个时刻看来Openclaw本身并未发明新的技术,也没有发明新的理念,他火起来的原因之一是以较低的门槛高度整合了当前社区和生态体系中的多个工具,尤其是集成了欧美主流的即时通信软件的插件,包括苹果iMessage、Whatsapp、Telegram、Singal等。此外在MacOS上整合了许多Mac原生能力,具备了快速接收任务、分派任务、监督多个任务执行的能力。Openclaw通过MCP、Skill等2026年已经很成熟的协议与外部第三方工具互动,用户可在各种场景下利用Openclaw帮助安排工作、监控执行进度,出现了许多有趣玩法,进一步提高了Openclaw知名度。Openclaw在Github开源,可快速部署上手。国内许多技术社区都可以找到丰富的图、文、视频教程。

Openclaw本身是agent工具,需要依赖外部大语言模型工作,开放的体系使得他可以调用OpenAI GPT、Anthropic Claude、Qwen、Deepseek等国内外各种模型,并不局限在任何一个模型供应商或云厂商,用户选择模型的范围几乎无限大。Openclaw被设计为长期运行一直在线(24小时)的个人助手,对云端模型调用消耗Token是比较大的。如果将Openclaw放在Mac Mini上运行,不仅可以与苹果原生生态许多APP互动,还可以借助Mac系列M处理器+统一内存硬件组合,在Mac Mini本地运行特定尺寸的模型完成所有推理,由此完全不需要消耗云端模型的Token,实现完全的Token自由。

二、在Ubuntu上部署Openclaw

1、准备EC2操作系统环境

为了搭建这个环境,需要在云端一个Linux Ubuntu 24.04操作系统,建议部署在东京(ap-northeast-1)或者新加坡(ap-southeast-1)区域,因为距离中国大陆最近,从国内连接网络延迟最低。硬件架构选择x86_64或ARM均可,磁盘选择30GB gp3,网络选择默认VPC和具有Public IP(用于外网访问),保存好SSH密钥,安全规则组对外Inbound入站不开放任何端口,这样将显著提升安全,避免密码过于简单被侵入。

启动EC2完毕后,使用AWS控制台的Connect连接功能,选择Session Manager登陆到这个EC2。

首先升级操作系统:

sudo apt update

sudo apt upgrade -y

sudo reboot

安装Node软件包:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash

\. "$HOME/.nvm/nvm.sh"

nvm install 24

npm install -g npm

检测安装好的版本:

node -v

npm -v

需要确认返回结果node>=22, npm>=11。

准备工作完毕。

2、生成一个只能调用模型的最低权限的Access Key/Secret Key

使用Openclaw需要调用模型,要求配置一个可以访问bedrock的AKSK。注意这个AKSK建议不要具有管理员权限,而是只有Bedrock调用权限。

建议操作方法是:

- 登陆到AWS控制台,切换到要使用模型的region

- 进入Bedrock服务,点击左侧的Bedrock API Key,生成一个单一密钥的API Key(但是后续暂时不使用)。

- 进入IAM服务,找到刚才上一步创建Bedrock API Key的用户名,为这个用户名单独创建一个Access Key和Secret Key。此时本密钥只有模型调用权限。

保存好密钥,当前界面创建完毕后,密钥明文只显示一次,以后不再显示明文。忘记密钥的话,只能删除重新创建。

3、配置AWSCLI

提前配置Bedrock访问模型API的密钥

在本机安装AWSCLI最新版本,从官网下载。(注意选择x86_64或arm架构对应版本)

curl "https://awscli.amazonaws.com/awscli-exe-linux-x86_64.zip" -o "awscliv2.zip"

unzip awscliv2.zip

sudo ./aws/install

执行如下命令配置AWSCLI:

aws configure

分别输入Access Key和Secret Key,设置调用模型的正确的区域,本例为us-east-1。最后输出格式一步,一般配置为JSON即可。

4、设置环境变量

在EC2的Ubuntu Linux上安装,必须设置环境变量如下,否则后续服务启动失败。手工执行如下命令设置为当前Shell设置:

export XDG_RUNTIME_DIR="/run/user/$(id -u)"

export DBUS_SESSION_BUS_ADDRESS="unix:path=$XDG_RUNTIME_DIR/bus"

export AWS_PROFILE=default

export AWS_REGION=us-east-1

此外还需要配置系统环境变量,也加入以上几个变量。执行vim ~/.bashrc编辑,加入以上几行。

接下来设置属于用户的后台服务自启动。如果不执行这一步,后续OS重启时候,Openclaw不会自动启动。

sudo loginctl enable-linger $(whoami)

5、安装Openclaw

安装并执行初始化。

npm install -g openclaw@latest

等待几分钟安装完毕。

Openclaw是安装到/home/ubuntu/.nvm/versions/node/版本号/bin目录下的,根据您Node版本有所不同,如果路径不正确,请执行如下命令设置路径。

export PATH="/home/ubuntu/.nvm/versions/node/v24.13.0/bin:$PATH"

6、初始化并登陆

Openclaw初始化会询问一系列配置,如果答错的话,后续需要通过配置文件修改较为麻烦,因此这里谨慎看清选项再回答。执行如下命令启动配置。

openclaw onboard --install-daemon

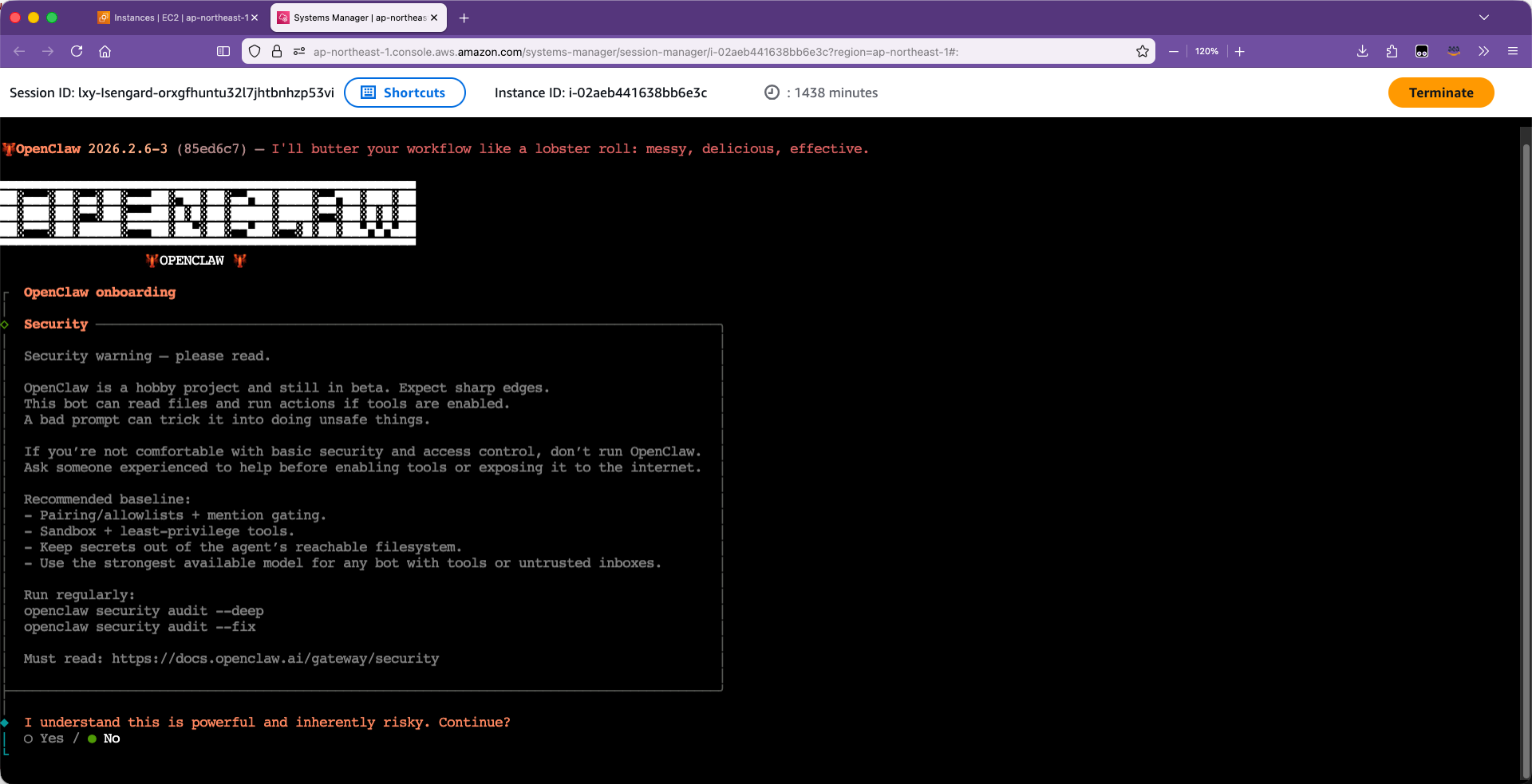

初始化向导界面视角如下。

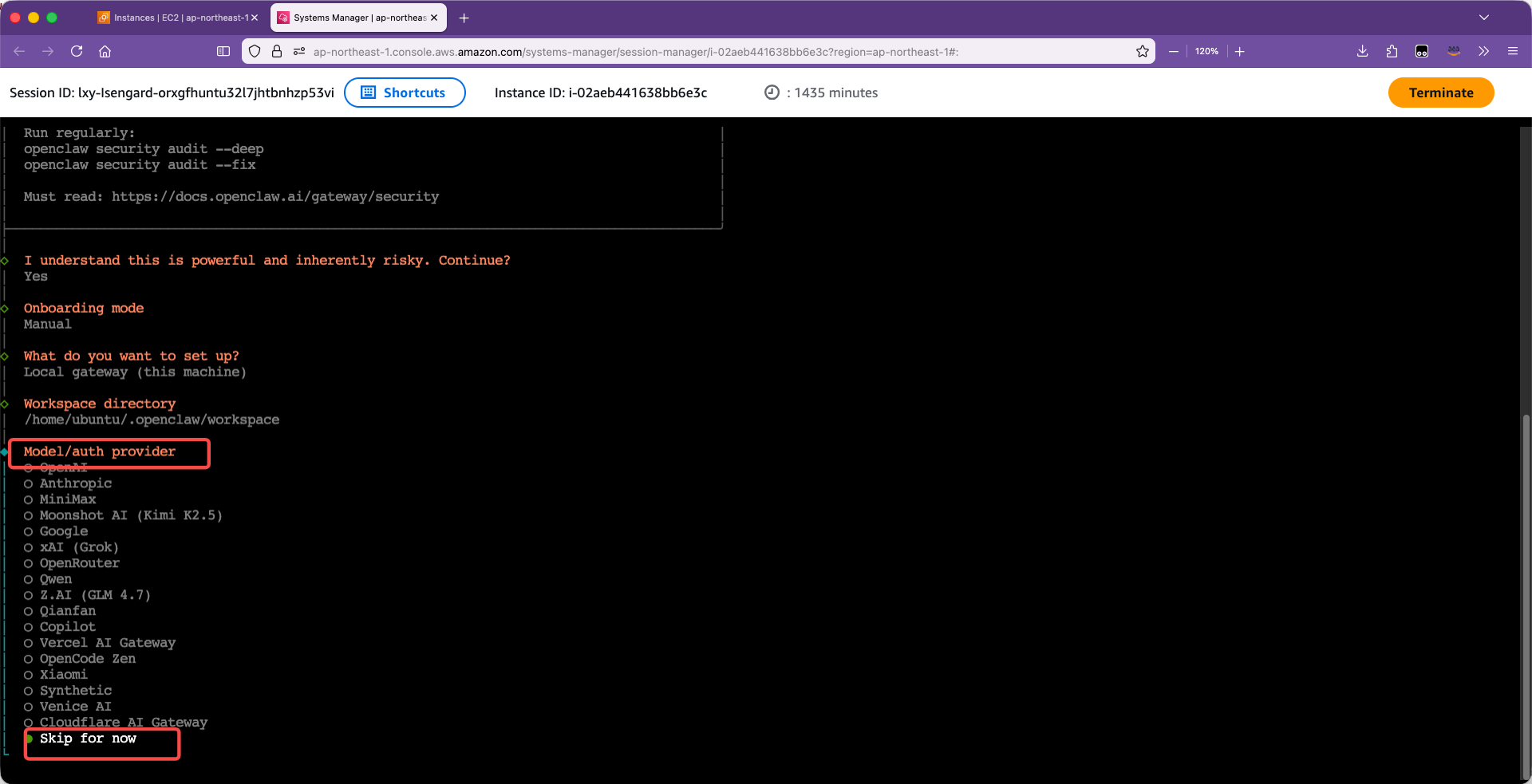

初始化选项如下(使用键盘上下箭头移动光标):

- I understand this is powerful and inherently risky. Continue? 选

Yes确认。 - Onboarding mode? 选

Manual手动配置。 - What do you want to set up? 选

Local gateway (this machine)。 - Workspace directory? 工作目录默认已经显示为

/home/ubuntu/.openclaw/workspace直接按回车即可。 - Model/auth provider? 这里选最后一项

Skip for now。注意这里一定不要选别的模型,这些选项他们都是模型原厂SaaS方式,并不是通过Amazon Bedrock来调用。

如下截图。

好继续选择更多选项:

- Filter models by provider? 选

amazon-bedrock - Default model? 选

Keep current (default: anthropic/claude-opus-4-6)。如果您希望选择其他版本的模型,可以用键盘上下键切换。 - Gateway port? 默认已经有

18789端口了,直接按回车继续。 - Gateway bind? 默认是

Loopback (127.0.0.1),直接按回车继续。这里一定不要绑定在0.0.0.0,这样很可能被从公网访问和扫描,对于密码较弱的情况,会被攻击。 - Gateway auth? 默认是

Token (Recommended default (local + remote))。直接按回车。 - Tailscale exposure? 这项是外部映射和内网暴露工具,选择默认

Off (No Tailscale exposure)即可。 - Gateway token (blank to generate)? 这是本机认证,手工设置一个比较复杂的比较长的,输入完毕按回车。

- Configure chat channels now? 是否配置聊天工具,这里选不配置

No。 - Configure skills now? (recommended)? 是否配置Skill技能,这里选不配置

No。 - Enable bash shell completion for openclaw? 这里选

Yes。

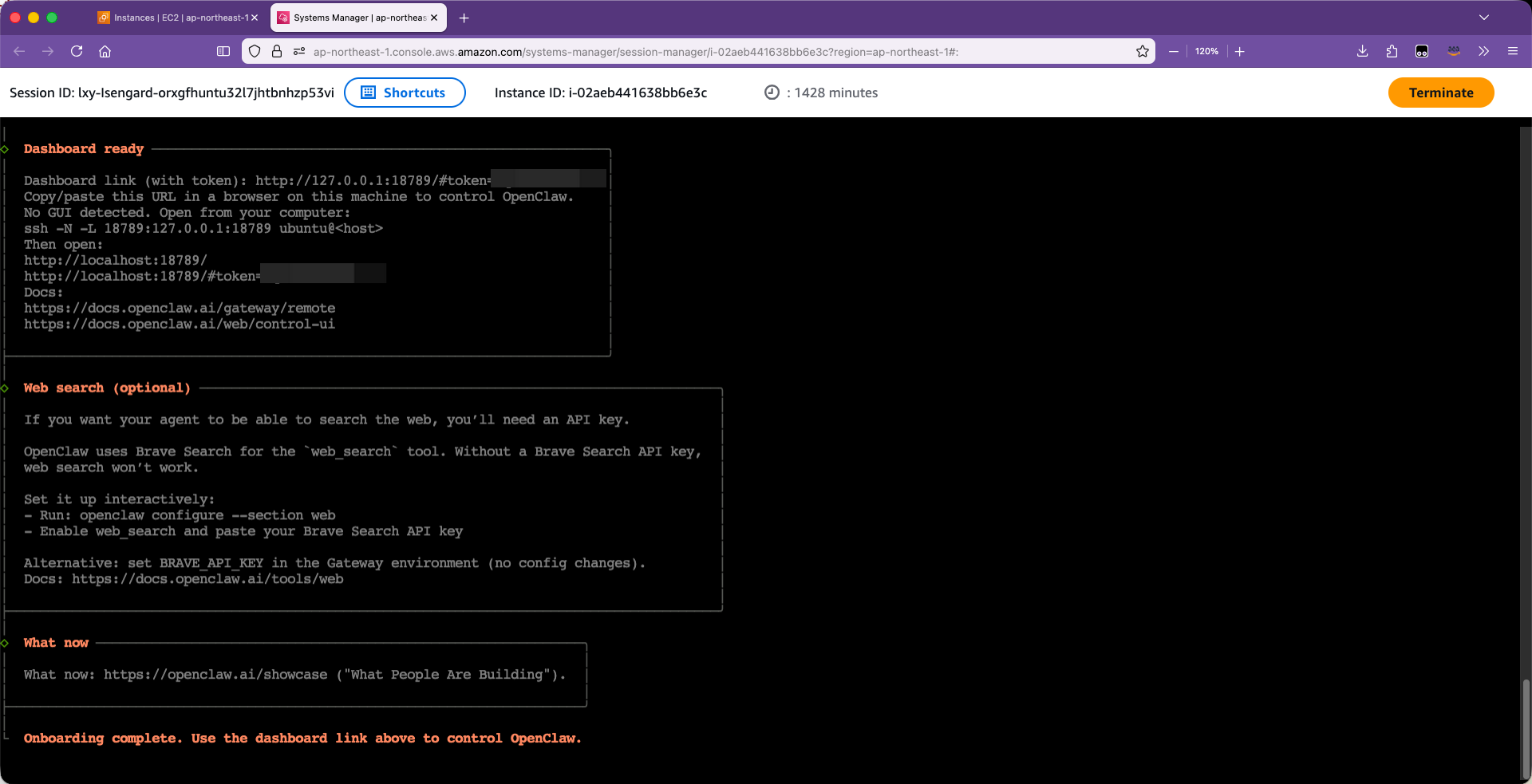

配置完成。此时界面不会自动退出,要按Ctrl+C才会退出。

7、配置Bedrock的Access Key和Secret Key为Openclaw的模型供应商

准备如下一段配置文件(需要的话可以替换其中的region和模型id:

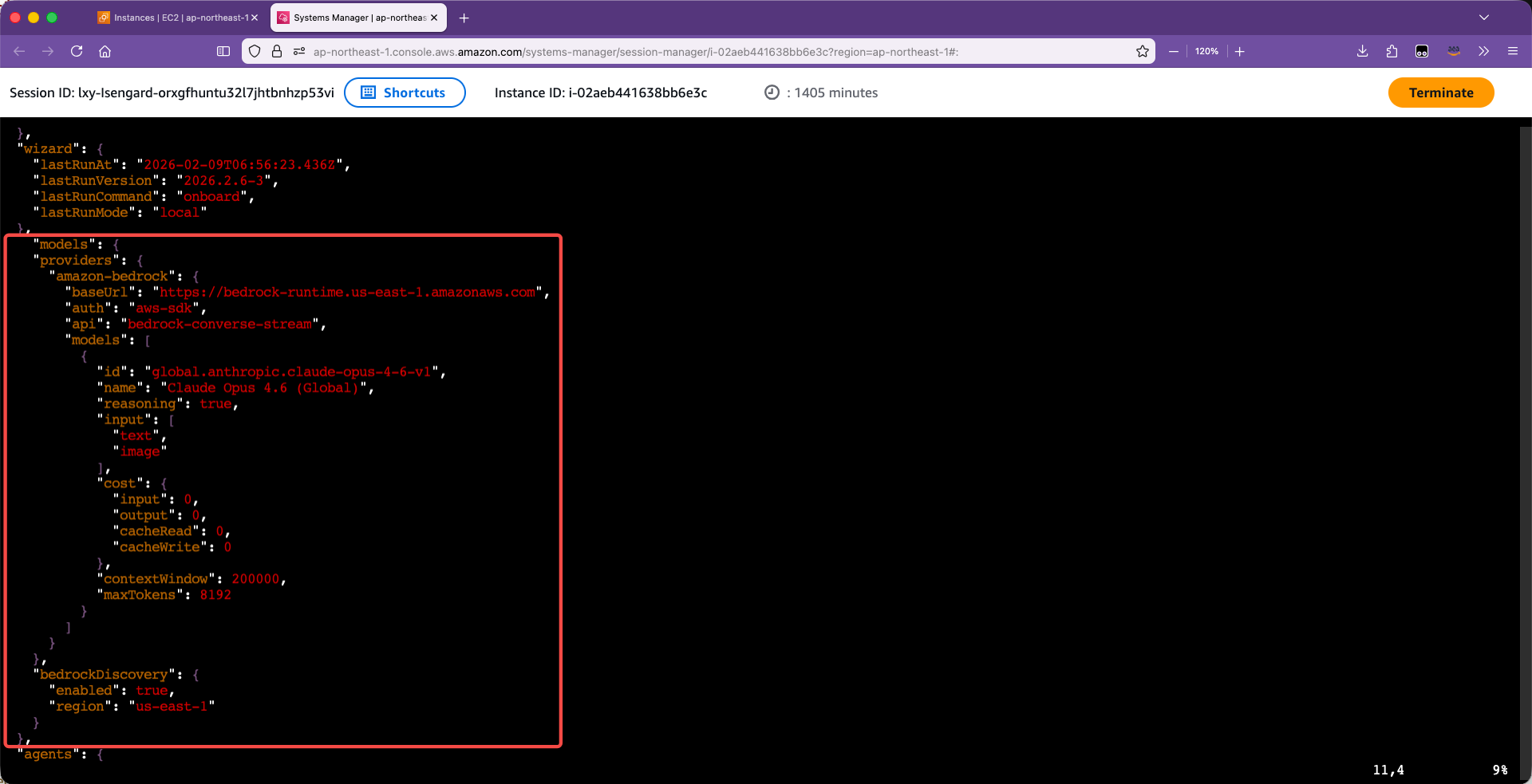

"models": {

"providers": {

"amazon-bedrock": {

"baseUrl": "https://bedrock-runtime.us-east-1.amazonaws.com",

"auth": "aws-sdk",

"api": "bedrock-converse-stream",

"models": [

{

"id": "global.anthropic.claude-opus-4-6-v1",

"name": "Claude Opus 4.6 (Global)",

"reasoning": true,

"input": [

"text",

"image"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 200000,

"maxTokens": 8192

}

]

}

},

"bedrockDiscovery": {

"enabled": true,

"region": "us-east-1"

}

},

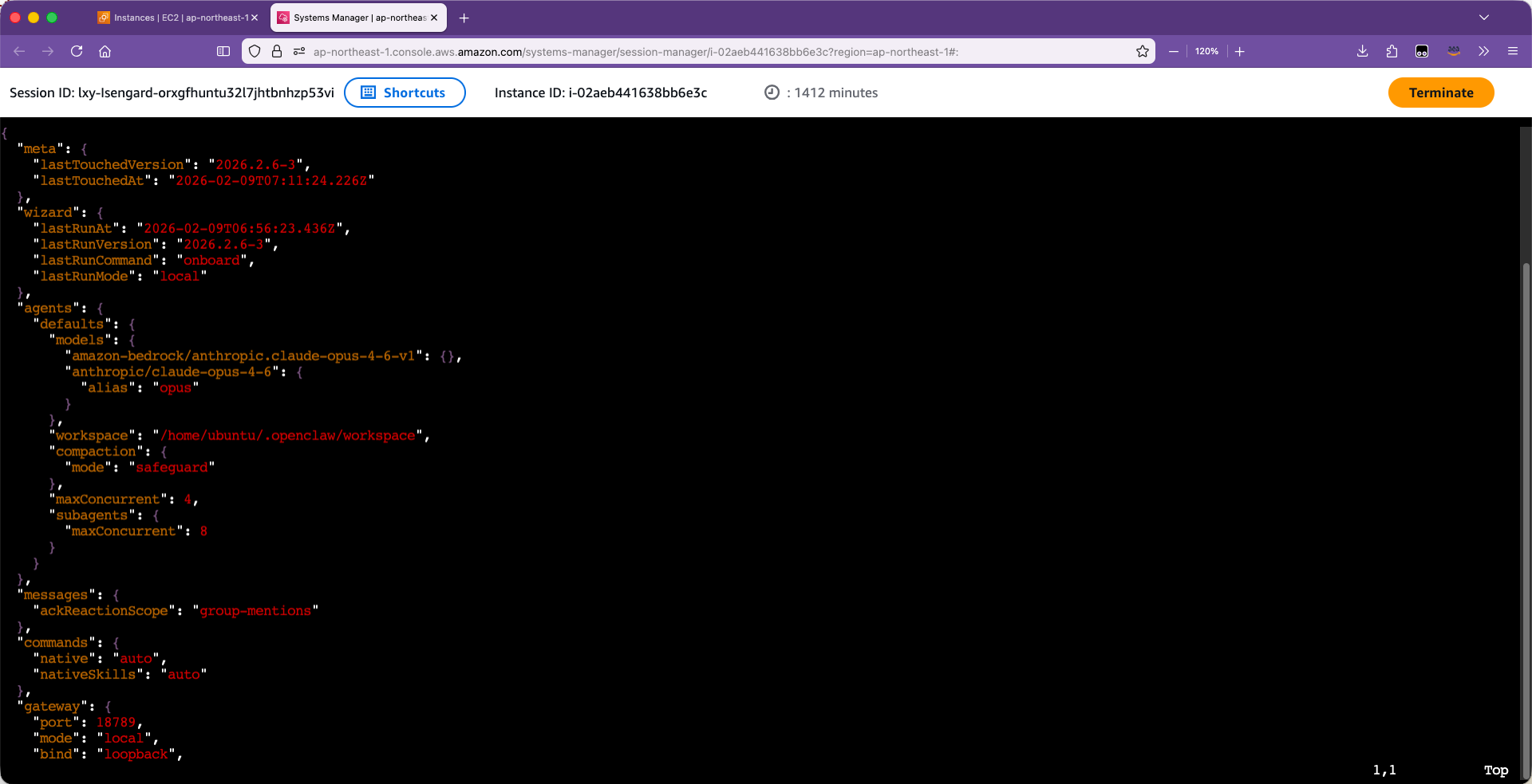

将其加入~/.openclaw/openclaw.conf。编辑如下配置文件:

vim ~/.openclaw/openclaw.conf

加入配置文件后,需要与现有wizard、agents等配置的目录平级,注意缩进的对齐。效果如下:

保存退出。然后重启服务:

openclaw gateway restart

注意:以上重启服务命令的前提是前文标题4、设置环境变量中设置的环境变量正确,否则这一步会报错。

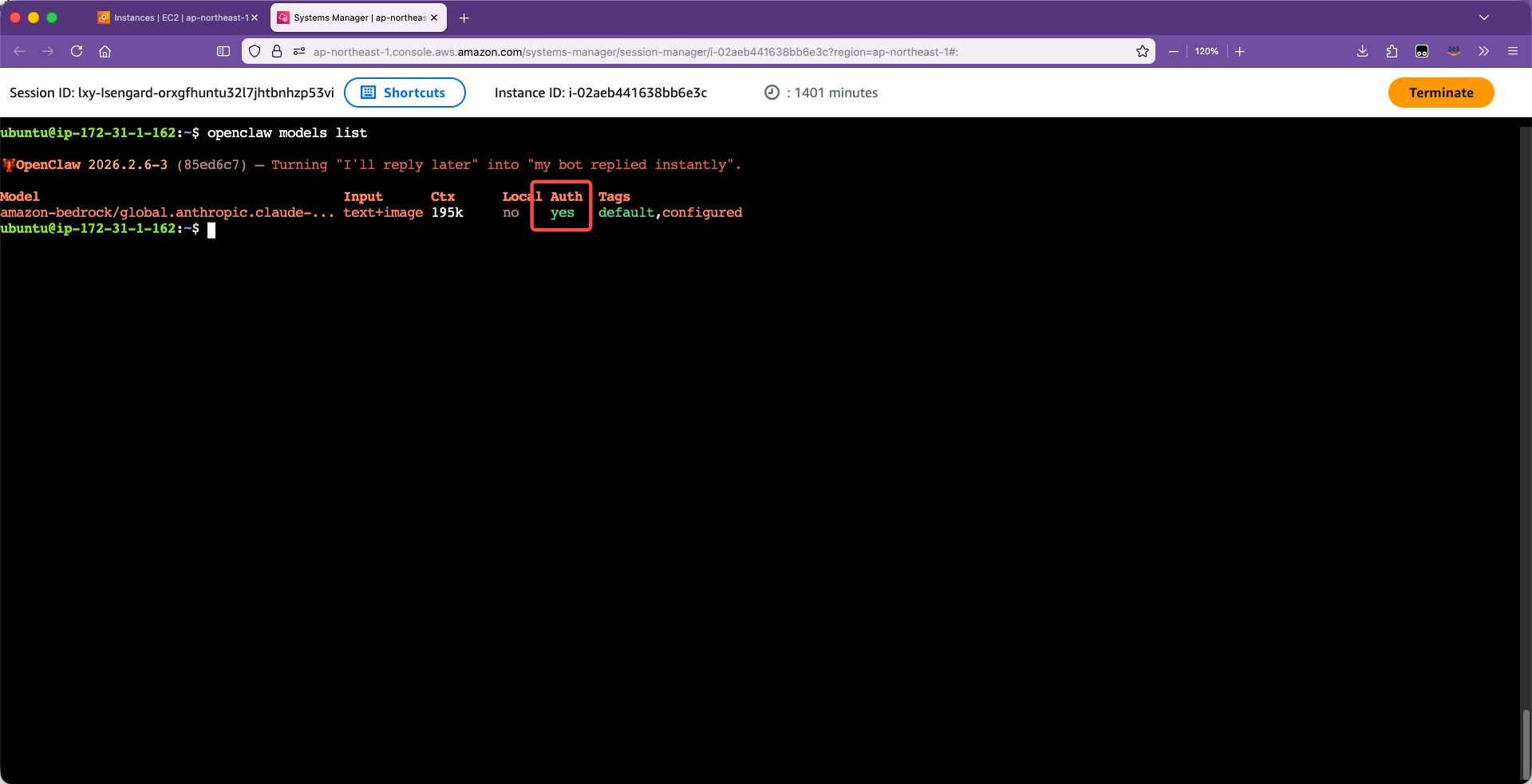

验证初始化成功,确认可用模型:

openclaw models list

返回结果如下:

Model Input Ctx Local Auth Tags

amazon-bedrock/global.anthropic.claude-... text+image 195k no yes default,configured

注意以上返回结果,在列出的模型这里,Auth部分一定要看到Yes才可以继续。由此配置完成。

8、将Openclaw加入自动启动

执行如下命令:

systemctl --user enable openclaw-gateway

systemctl --user is-enabled openclaw-gateway

sudo loginctl enable-linger ubuntu

这几条命令的前提是前文标题4、设置环境变量中设置的环境变量正确,否则这一步会报错。

设置成功后,Openclaw就可以随EC2重启而自动启动了。

三、访问Openclaw

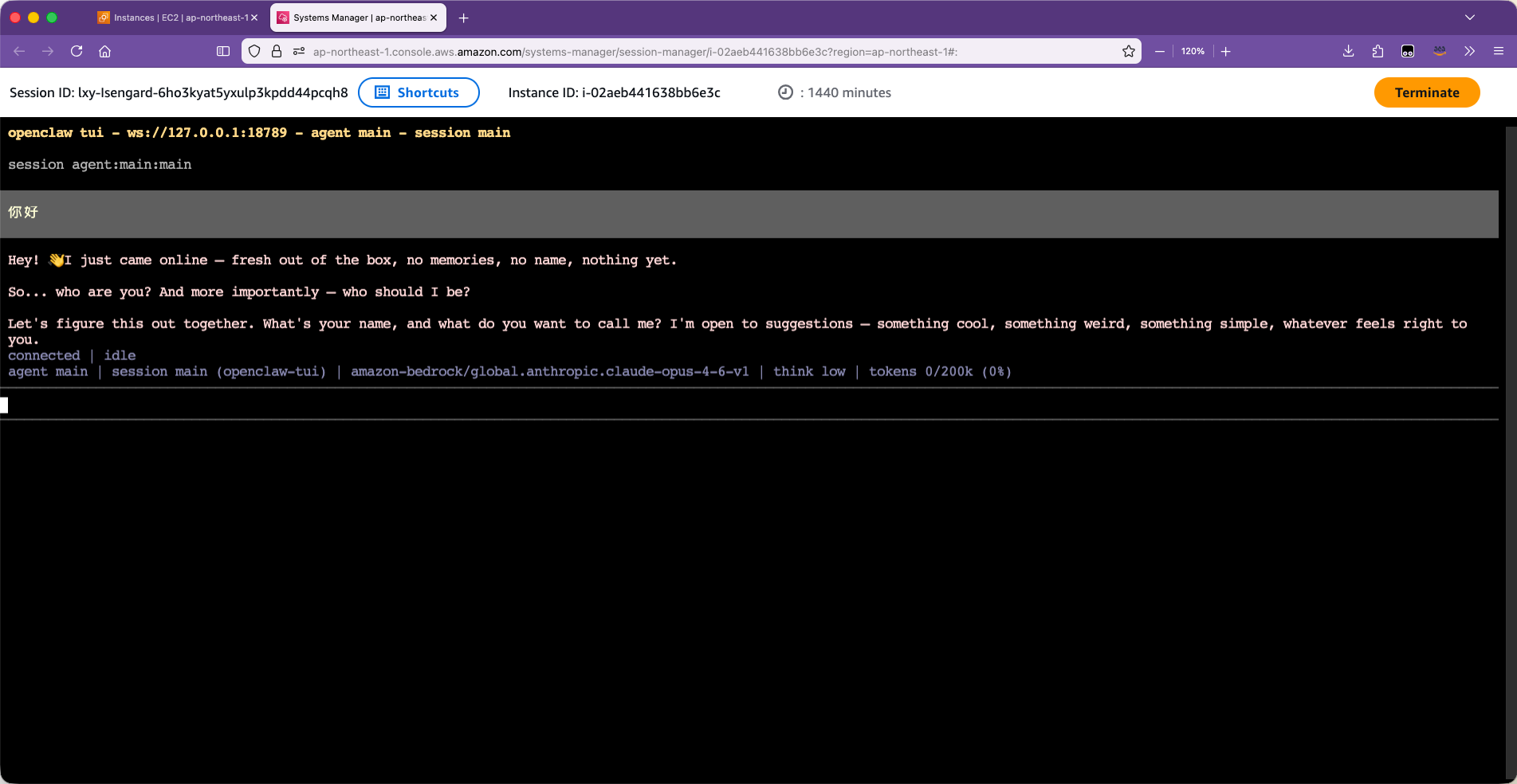

1、使用TUI(Terminal UI)图形界面和Openclaw聊天(可选)

经过以上配置,EC2的127.0.0.1:18789端口已经有Openclaw再跑了。执行如下命令,可启动命令行下的Openclaw聊天程序。

openclaw tui --token xxxxxxxx(前边初始化时设置的token)

连接成功后,即可在聊天窗口发起对话,并得到模型的反馈。如下截图。

2、启动SSH转发到本地并使用WEB界面登陆

为了安全起见,我们回到开发者本机来做端口转发。

以下命令在开发者本机进行。安装AWSCLI的session-manager的plugin。请参考官方文档这里获取安装包:

本文以使用M1处理器(ARM架构)的Mac电脑为例:

curl "https://s3.amazonaws.com/session-manager-downloads/plugin/latest/mac_arm64/session-manager-plugin.pkg" -o "session-manager-plugin.pkg"

sudo installer -pkg session-manager-plugin.pkg -target /

sudo ln -s /usr/local/sessionmanagerplugin/bin/session-manager-plugin /usr/local/bin/session-manager-plugin

安装完毕。

在EC2控制台上查看下当前安装Openclaw的EC2的区域和ID,然后构建如下命令。编辑本机的shell环境变量文件,例如bash就是~/.bashrc,加入如下一行:

alias openclaw="aws ssm start-session --target i-02aeb441638bb6e3c --region ap-northeast-1 --document-name AWS-StartPort ForwardingSession --parameters '{\"portNumber\":[\"18789\"], \"localPortNumber\":[\"18789\"]}'"

重新加载环境变量:

source ~/.bashrc

现在执行运行openclaw即可将安装Openclaw的EC2的18789端口转发到本地的18789。

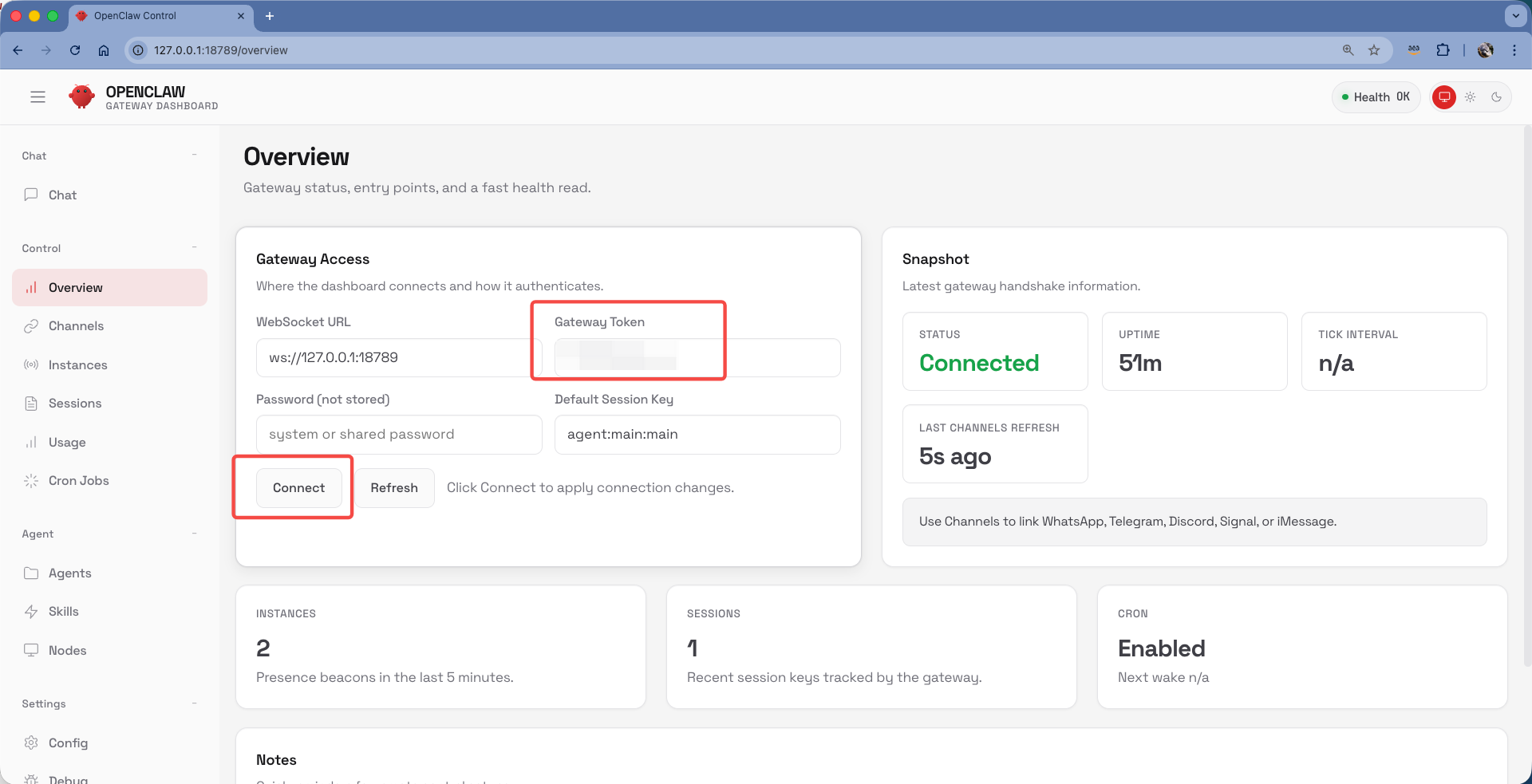

启动浏览器,访问http://127.0.0.1:18789,然后输入初始化向导时候设置的token,点击connect即可连接到Openclaw。

现在即可通过Web界面与Openclaw聊天。

四、Openclaw对接到飞书作为机器人与用户交互

注意:

- 飞书机器人要想被外部应用调用,必须进行版本发布操作。如果您是飞书企业用户,这一步需要您的企业管理员审批。因此请咨询您的飞书管理员您是否可以发布飞书机器人。

- 如果您是飞书个人用户,那您创建的飞书机器人只可以和自己说话,无法添加到与别人的对话中。与其他人互动的飞书机器人要求必须是企业账号、且完成企业营业执照审核才可以。本文演示的飞书机器人在飞书个人版上测试通过。

1、在Openclaw的EC2上安装飞书channel插件

从2026年2月起新安装的Openclaw,已经内置了飞书插件了。无须手工安装。

2、在飞书平台创建新的机器人、设置能力、获取app id和key id

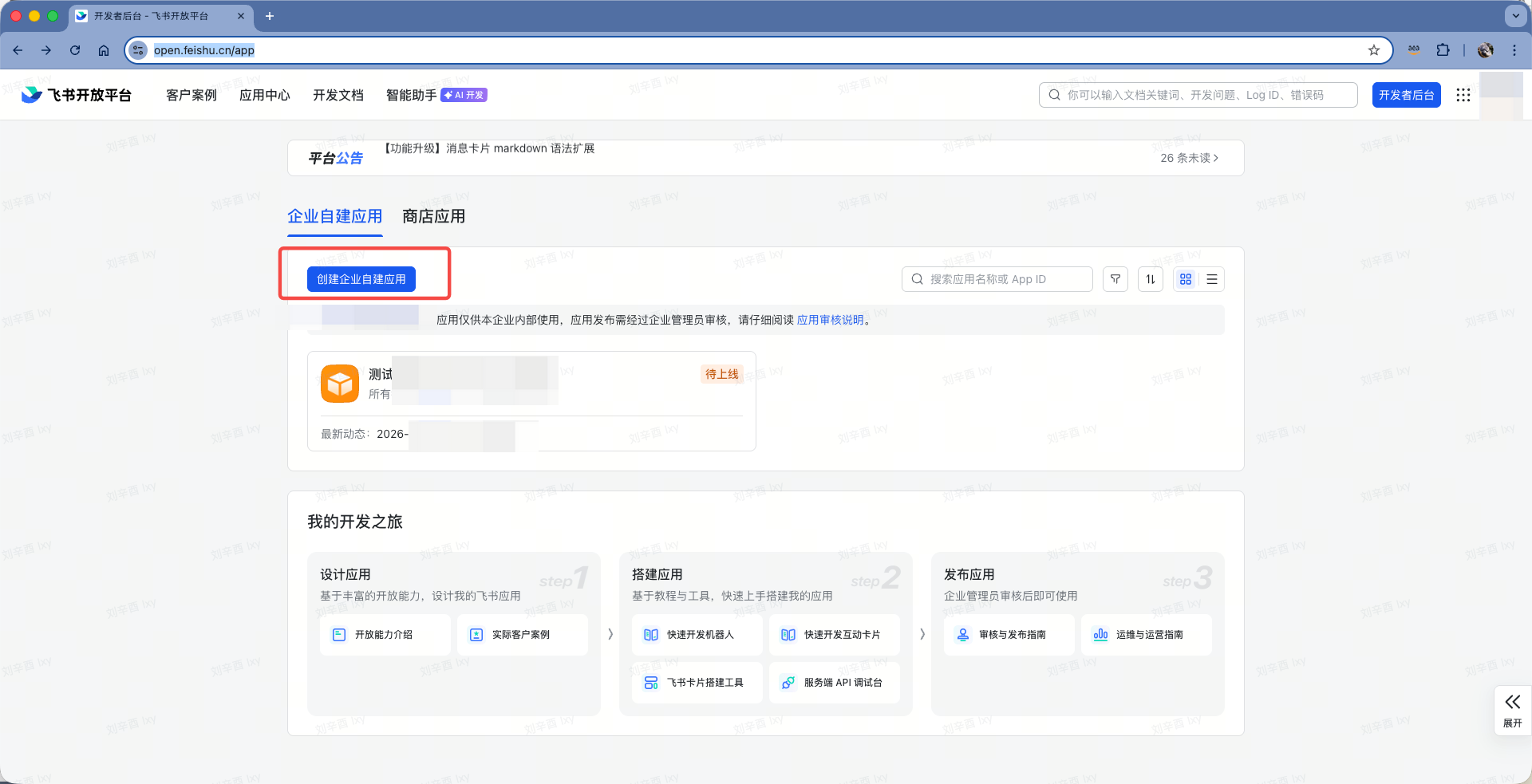

进入飞书开放平台:https://open.feishu.cn/app,点击创建企业应用按钮。如下截图。

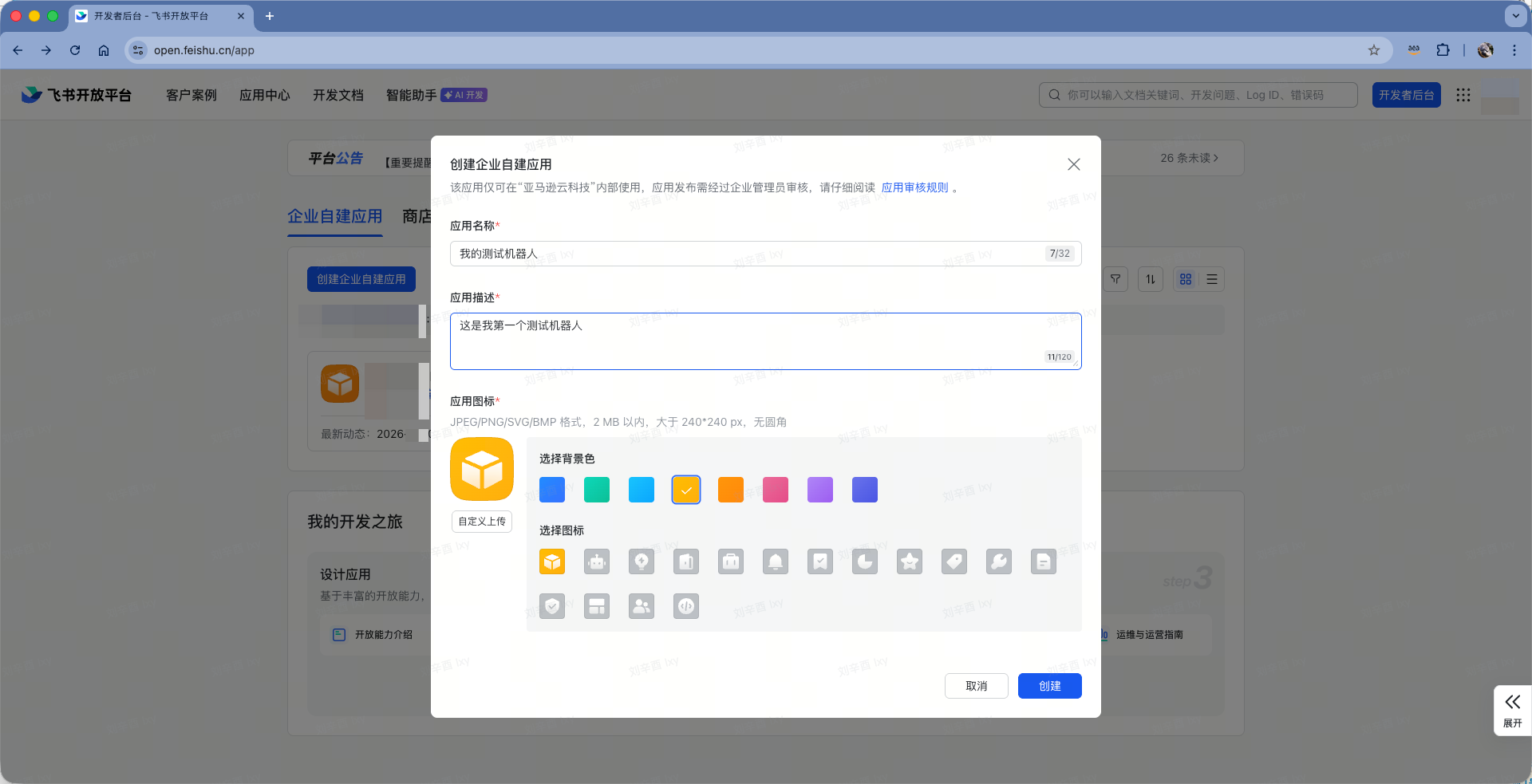

在创建自定义应用的弹出对话框内,输入名称。点击创建按钮。如下截图。

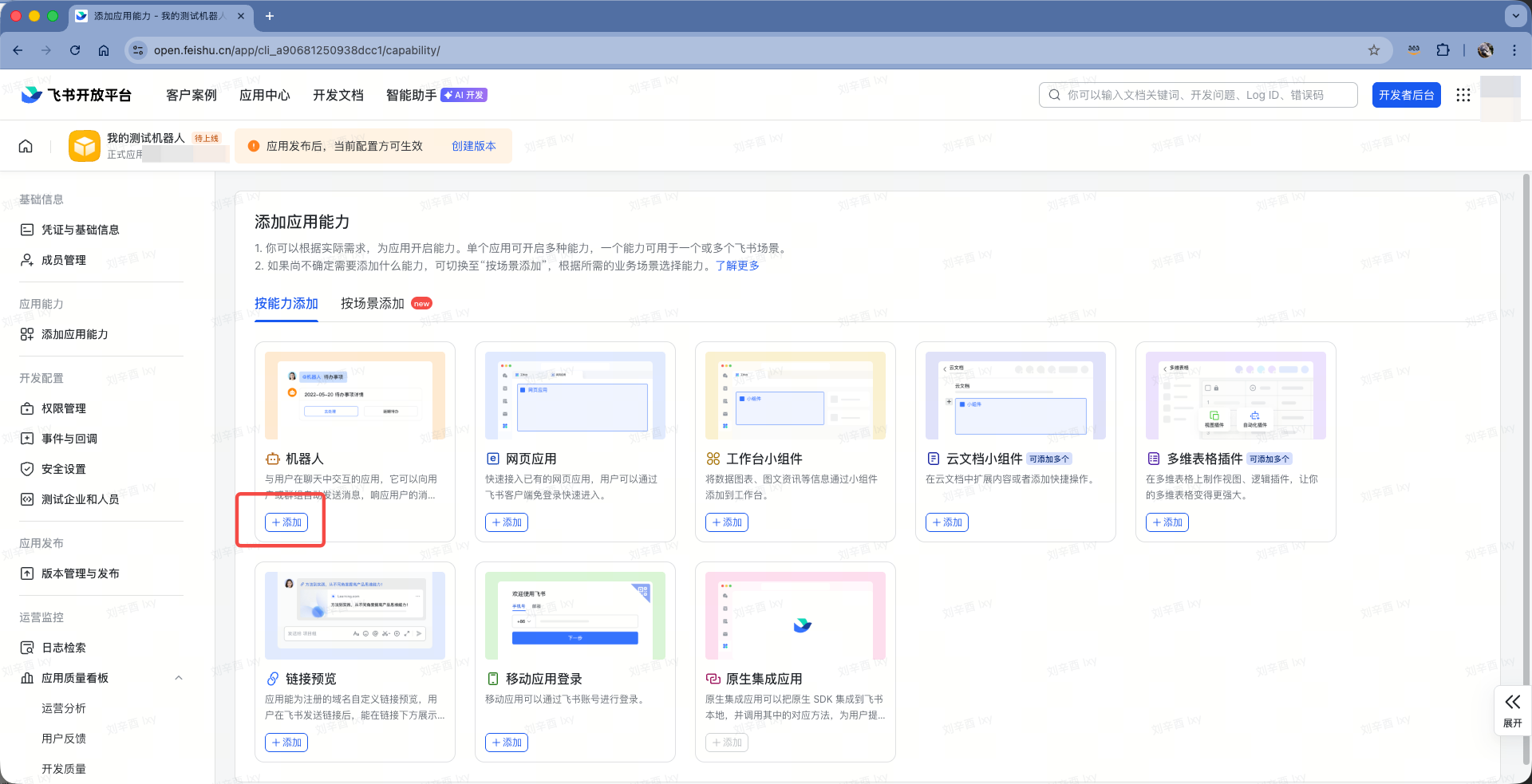

在向导创建完成的时候,会自动切换到能力界面,这里点击第一项,这个自定义应用的能力是机器人。如下截图。

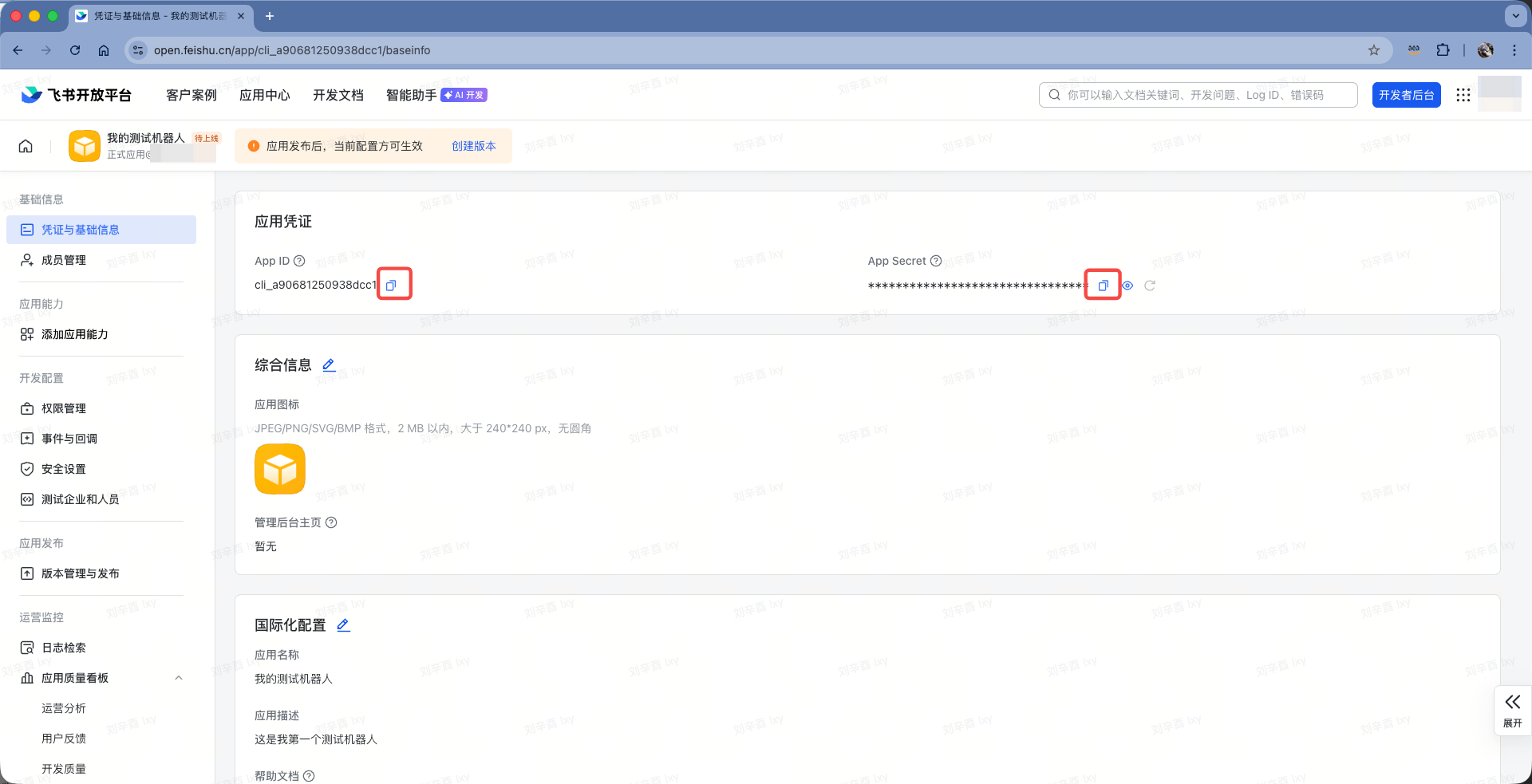

接下来点击左侧的凭证与基础信息菜单,从右侧复制下来app id和key id两个值,后续代码将会使用。如下截图。

获得app id和key id步骤完成。

3、配置授权机器人可以做的行为

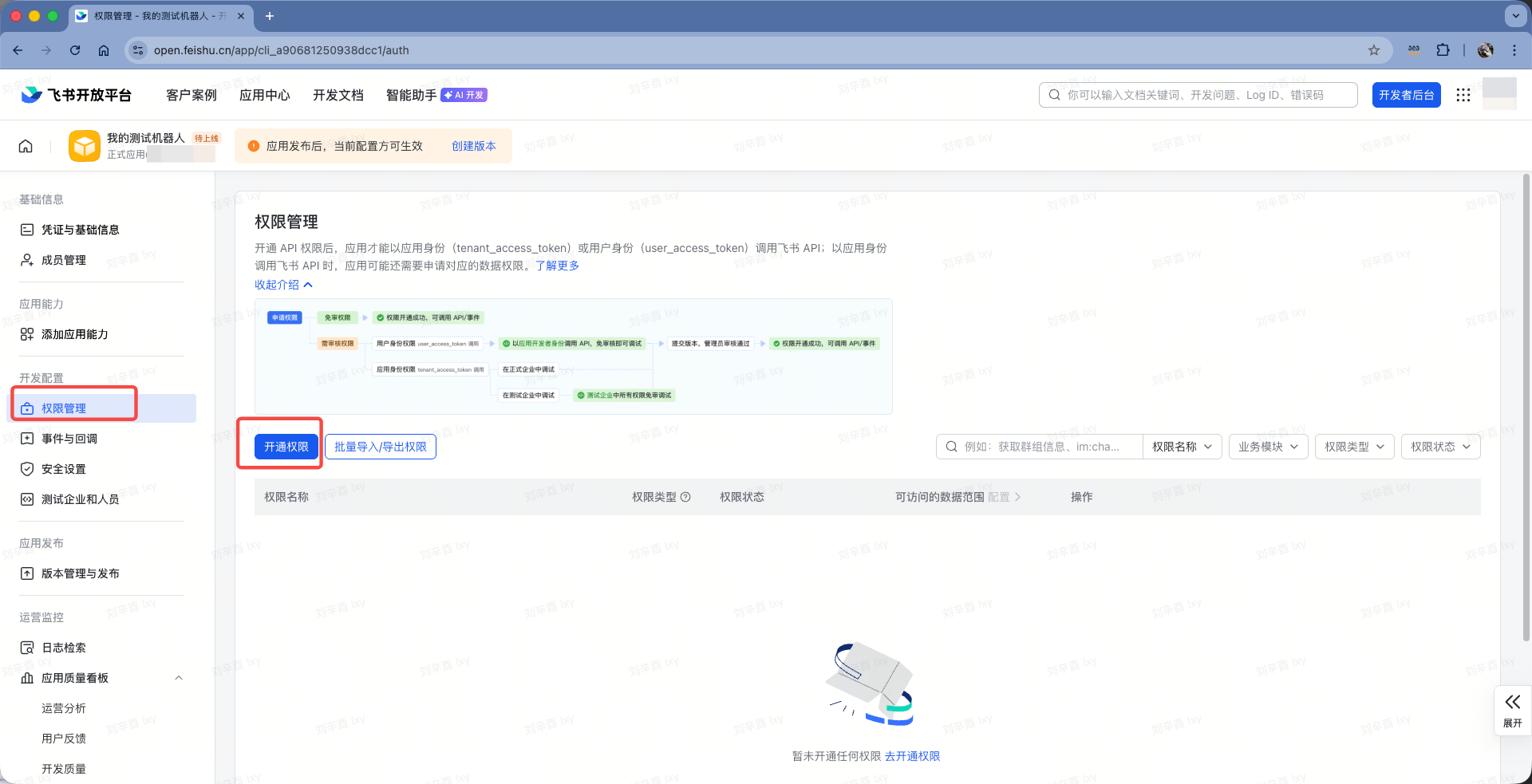

继续配置机器人。在左侧菜单开发配置下,点击权限管理。点击右侧的开通权限按钮。如下截图。

在开通权限对话框内,搜索关键字,找到如下权限后,点击确认开通权限按钮。如下截图。

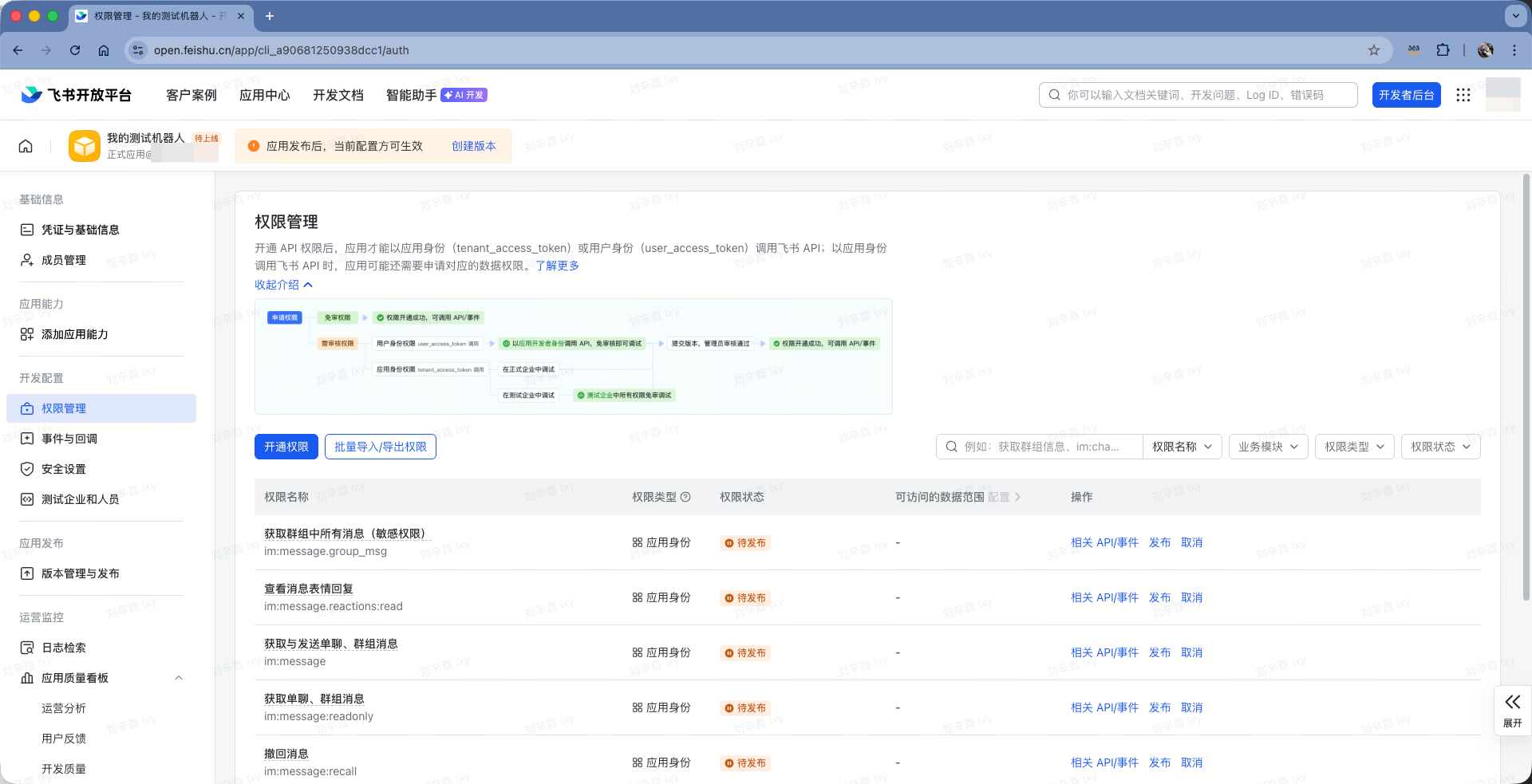

要开通的权限列表包括:

| 权限 | 范围 | 说明 |

|---|---|---|

im:message |

消息 | 发送和接收消息 |

im:message:update |

编辑 | 更新/编辑已发送消息 |

im:message:readonly |

读取 | 获取历史消息 |

im:message:recall |

撤回 | 撤回已发送消息 |

im:message:send_as_bot |

发送 | 以机器人身份发送消息 |

im:message.group_at_msg:readonly |

群聊 | 接收群内 @机器人 的消息 |

im:message.group_msg |

群聊 | 读取所有群消息(敏感) |

im:message.p2p_msg:readonly |

私聊 | 读取发给机器人的私聊消息 |

im:message.reactions:read |

表情 | 查看消息表情回复 |

im:resource |

媒体 | 上传和下载图片/文件 |

contact:user.base:readonly |

用户信息 | 获取用户基本信息(用于解析发送者姓名,避免群聊/私聊把不同人当成同一说话者) |

都添加好了后界面如下截图。

至此权限配置完成。

4、用测试代码建立长连接

接下来要测试应用程序和飞书后台API的链接特性。只有外部应用使用API连接成功,才可以继续在飞书开放平台上配置事件功能。如果这里没有先进行连接,那么后续配置会提示尚未连接。

在运行Openclaw的Linux上安装Python的包管理工具uv,并安装飞书API包,然后初始化Python环境。执行如下命令:

curl -LsSf https://astral.sh/uv/install.sh | sh

uv init .

uv venv

source .venv/bin/activate

uv add lark-oapi

创建lark.py代码,内容如下:

import lark_oapi as lark

def do_p2_im_message_receive_v1(data: lark.im.v1.P2ImMessageReceiveV1) -> None:

print(f'[ receive ], data: {lark.JSON.marshal(data, indent=4)}')

event_handler = lark.EventDispatcherHandler.builder("", "") \

.register_p2_im_message_receive_v1(do_p2_im_message_receive_v1) \

.build()

cli = lark.ws.Client("YOUR_APP_ID", "YOUR_APP_SECRET",

event_handler=event_handler,

log_level=lark.LogLevel.DEBUG)

cli.start()

替换上文中的YOUR_APP_ID和YOUR_APP_SECRET为真实值。然后执行如下命令运行程序:

uv run lark.py

连接成功返回结果如下:(返回信息已脱敏)

[Lark] [2026-02-11 08:46:01,055] [INFO] connected to wss://msg-frontier.feishu.cn/ws/v2?fpid=111&aid=11111&device_id=1111111111111&access_key=1111111111111111111111111&service_id=1111111111118&ticket=11111111111111111111111111111111111111111 [conn_id=111111111111111]

[Lark] [2026-02-11 08:46:01,056] [DEBUG] ping success [conn_id=1111111111111111]

[Lark] [2026-02-11 08:46:01,305] [DEBUG] receive pong [conn_id=1111111111111111]

连接成功后,先不要停止程序,而是保持程序打开状态,回到飞书控制台继续配置。

5、配置事件长连接

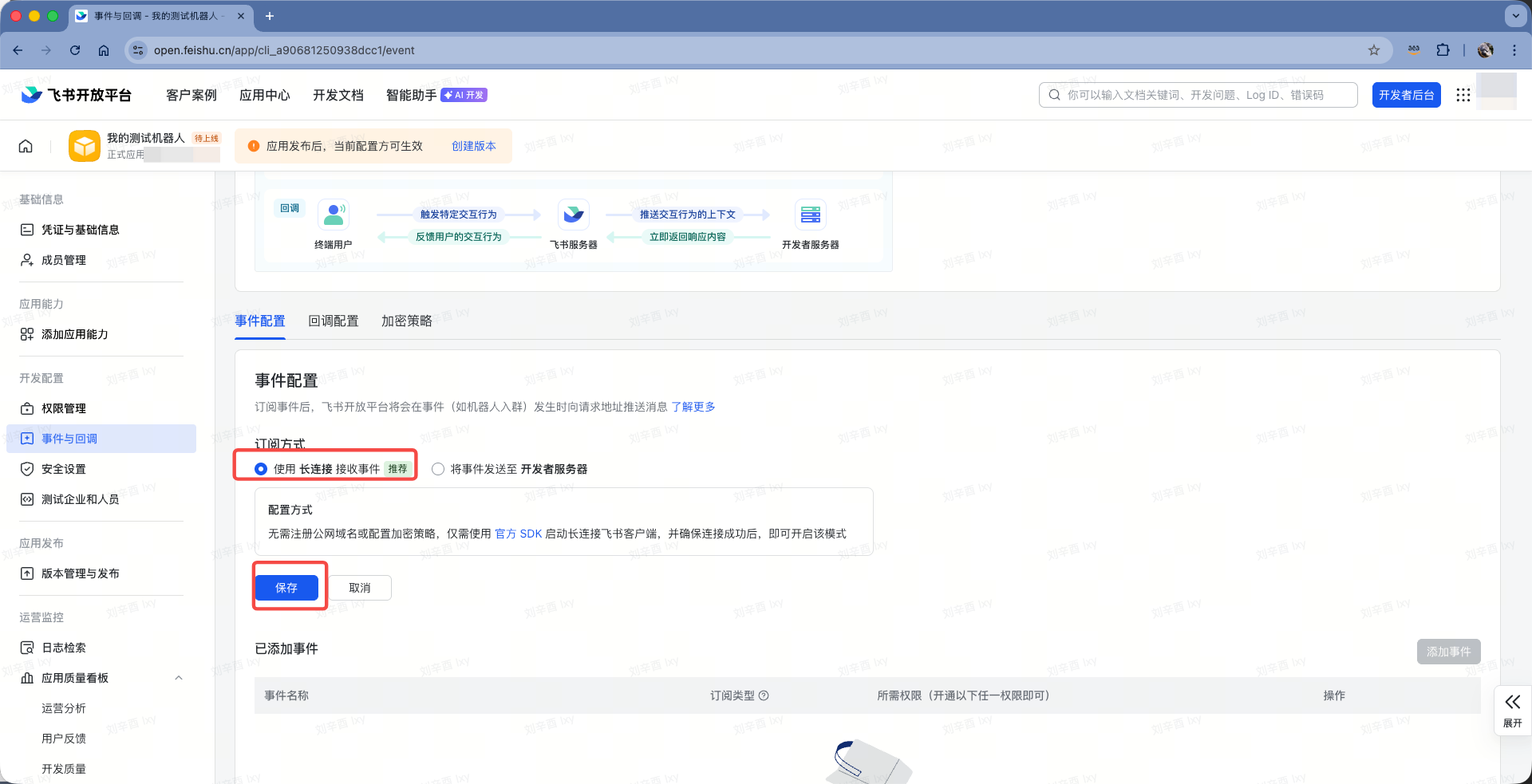

接上一步,确认python程序打开状态,也就是长连接一直活跃。然后在飞书开放平台左侧,点击事件与回调菜单,在右侧点击标签页事件配置,点击下方的订阅方式。如下截图。

在订阅方式位置,选择使用长连接接受事件(推荐),然后点击保存。如下截图。

此时需要确保上一步的Python程序是在活跃中,即可完成配置。

6、配置事件订阅

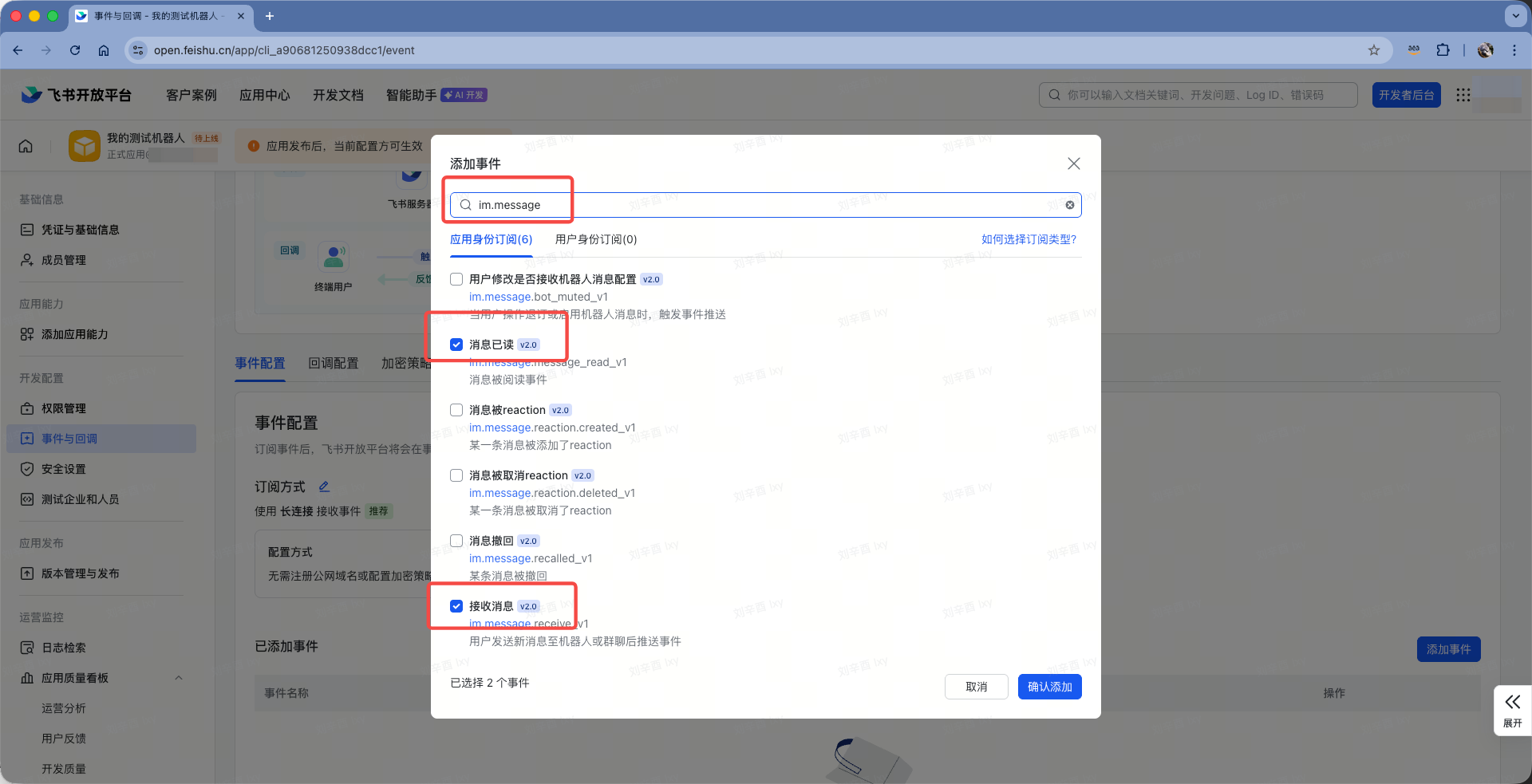

继续在刚才事件与回调界面,配置完毕长连接后,点击右下角的添加事件。如下截图。

在添加事件的对话框中,通过关键字搜索,添加如下事件。如下截图。

| 事件 | 说明 |

|---|---|

im.message.receive_v1 |

接收消息(必需) |

im.message.message_read_v1 |

消息已读回执 |

im.chat.member.bot.added_v1 |

机器人进群 |

im.chat.member.bot.deleted_v1 |

机器人被移出群 |

即可完成事件配置。

7、向飞书企业管理员申请发布机器人

注意:飞书机器人要想被外部应用调用,必须进行版本发布操作。如果您是飞书企业用户,这一步需要您的企业管理员审批。如果您是飞书个人用户,那您创建的飞书机器人只可以和自己说话,无法添加到与别人的对话中。与其他人互动的飞书机器人要求必须是企业账号、且完成企业营业执照审核才可以。

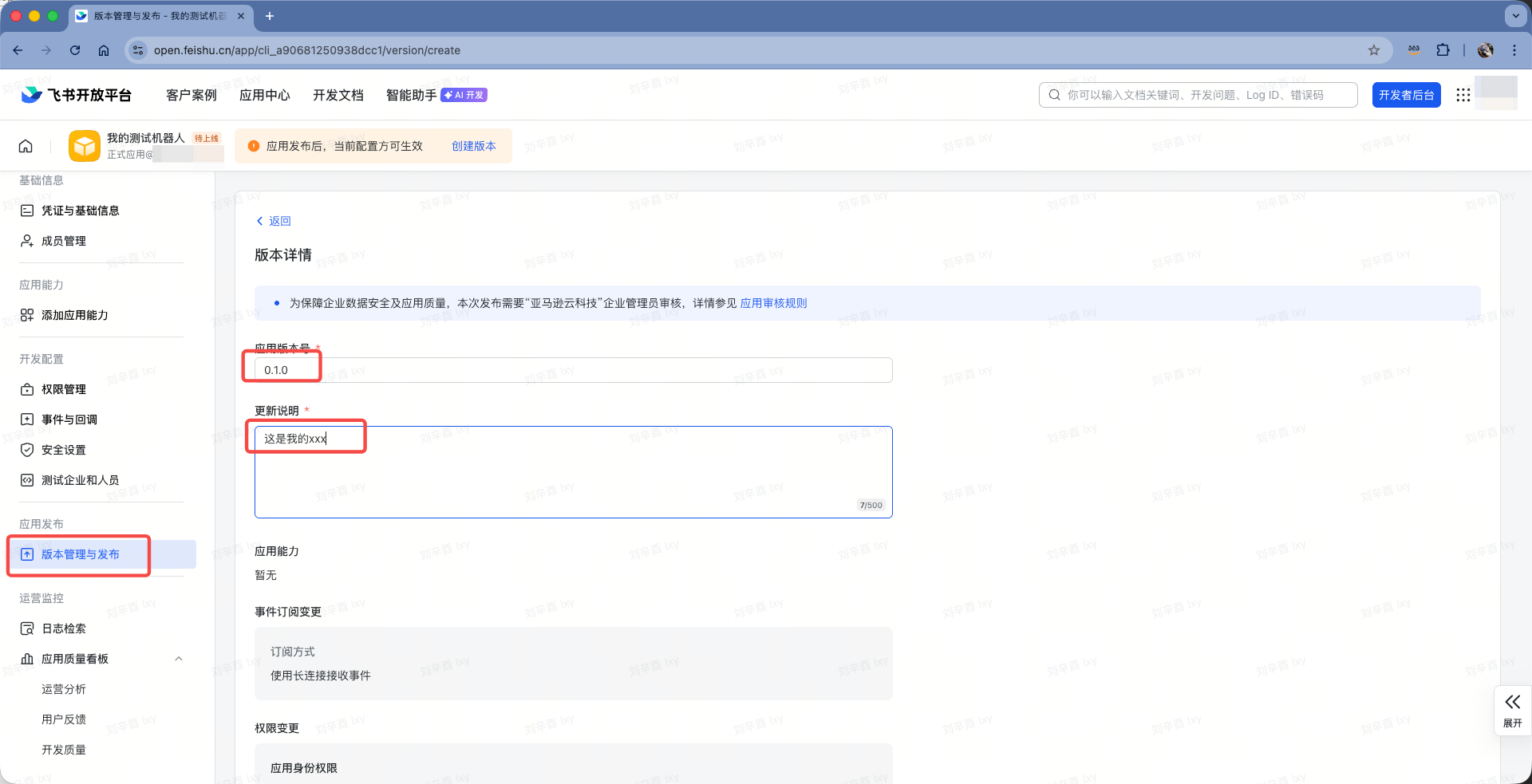

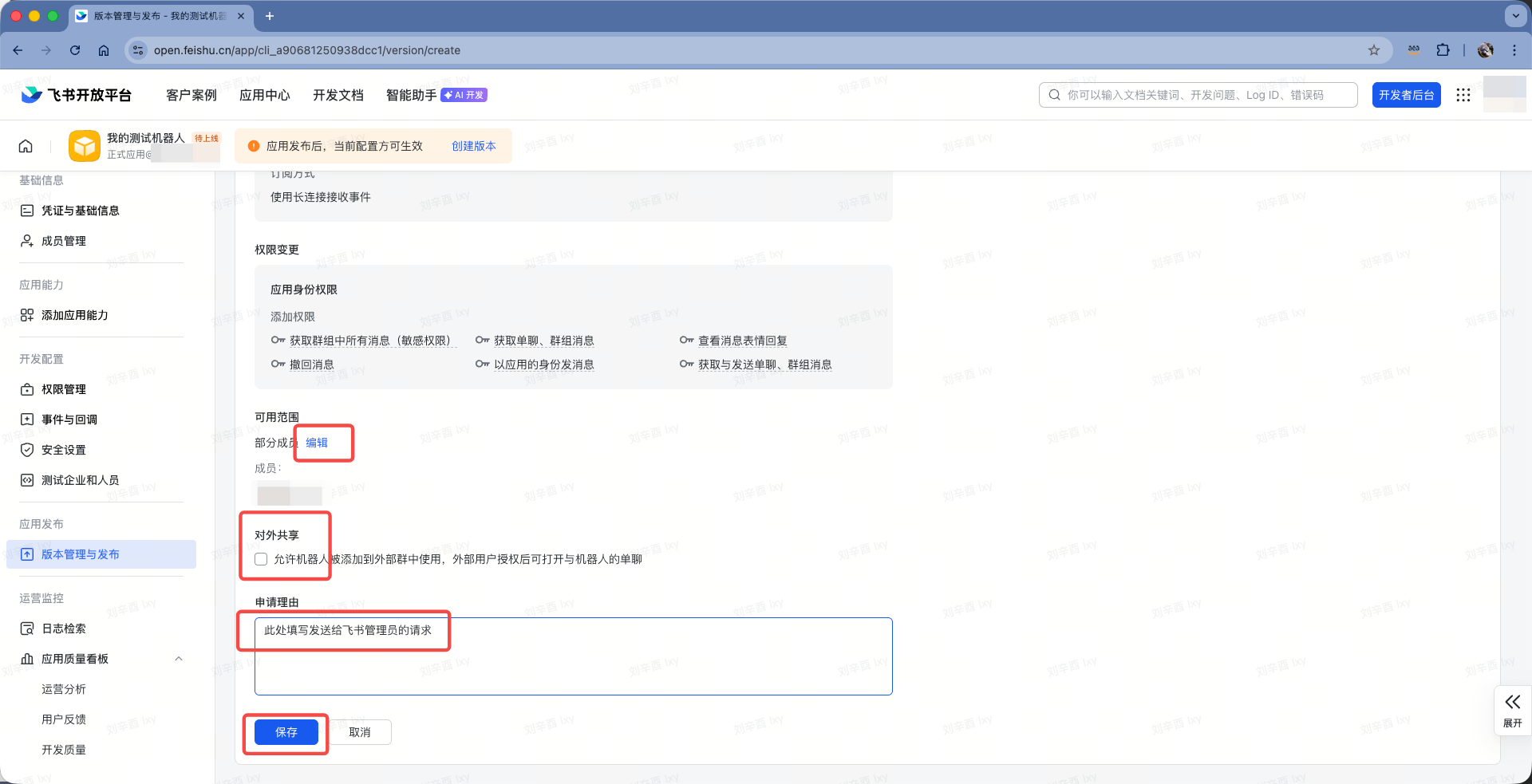

飞书机器人最后一步,就是提交发布申请。进入左侧应用发布菜单,点击版本管理与发布。在右侧点击发布版本,然后填写表单。注意版本号必须是x.x.x的格式。如下截图。

在发布申请下方,可选择向整个组织发布还是只向部分成员发布,可选是否对外共享,这都需要管理员审批。最后填写完整的申请理由信息。最后点击保存按钮就是提交申请了。如下截图。

等待您的管理员完成审批即可。

8、在Openclaw上注册飞书插件

Openclaw在2026年2月的版本已经包含了飞书插件,刚安装完毕时候,在后台管理Dashboard的Channel中没有显示,但实际已经包含了,只需要通过命令激活。登陆到安装Openclaw的节点上个,执行如下命令做配置:

openclaw config set channels.feishu.appId "xxxxxxxxxxxx"

openclaw config set channels.feishu.appSecret "xxxxxxxxxxxxxxxxxxxxxxxx"

openclaw config set channels.feishu.enabled true

openclaw gateway restart

配置完成。

9、飞书对话测试

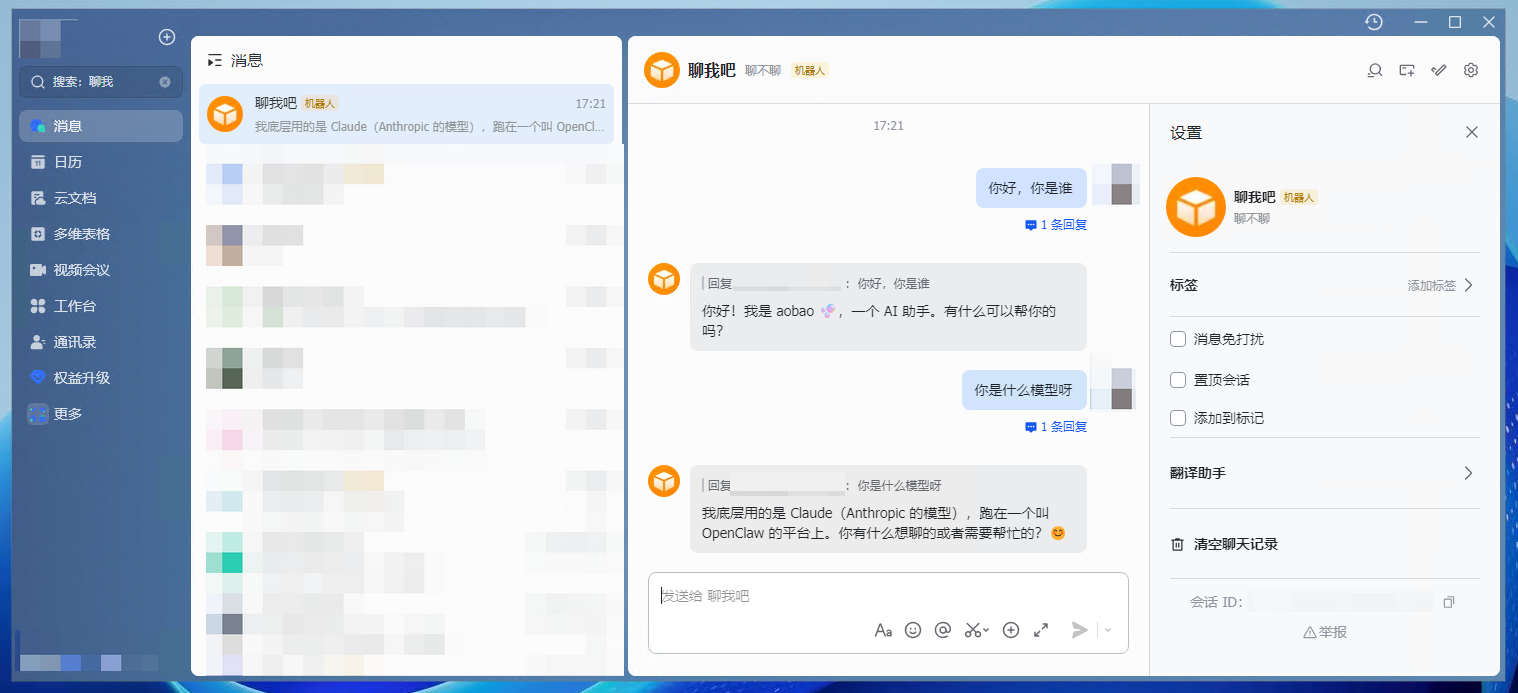

在飞书对话中,搜索你的机器人的命令,即可找到他。如下截图。

和他开始对话吧!

至此Openclaw+飞书对接完成。

五、参考文档

AWS官方公众号:在云端Mac Mini上部署Openclaw

https://mp.weixin.qq.com/s/0k62KUk6wveo1OEt72xI9Q

Openclaw的飞书配置说明

https://github.com/m1heng/clawdbot-feishu

一文完全搞懂 Clawd Bot(Moltbot/OpenClaw)附飞书对接指南!

https://www.feishu.cn/content/article/7602519239445974205

保姆级 OpenClaw (原 Clawdbot)飞书对接教程 手把手教你搭建 AI 助手

https://developer.aliyun.com/article/1709615

最后修改于 2026-02-11